¿Qué es la inteligencia artificial? Hablamos de inteligencia artificial (IA) cuando una máquina puede aprender a través de la experiencia para realizar tareas o solucionar problemas. Quizás relacionamos inteligencia artificial con robótica o, simplemente, nos parece ciencia ficción. Es mucho más que eso: cada día interactuamos con aplicaciones que incorporan la inteligencia artificial, a menudo sin ser conscientes (por ejemplo, las recomendaciones de compra de Amazon o los vídeos recomendados de Youtube). Amazon, Google, Microsoft, Nvidia y Facebook son las principales empresas que invierten en IA.

¿Y por qué debería preocuparnos la ética en este campo tecnológico? Porque el Deep Learning (el nuevo sistema de IA, toda una revolución) no sabe qué está bien y que está mal: solamente entiende de conseguir los objetivos fijados. Os lo contamos.

¿Qué es el Deep Learning?

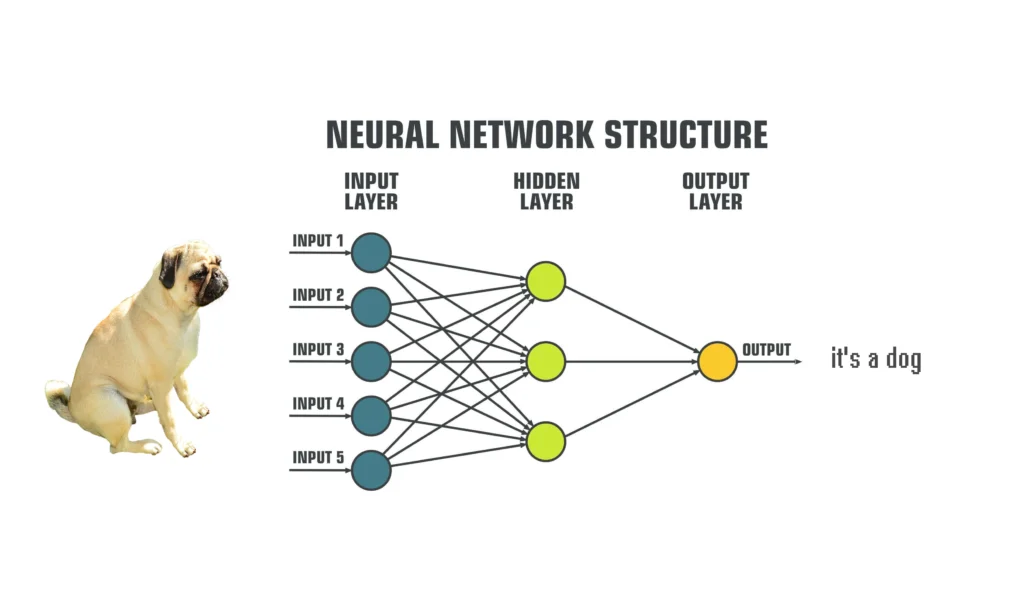

El Deep Learning se encuentra dentro del machine learning, un tipo de IA que consiste en hacer que la máquina se entrene para desarrollar correctamente tareas específicas. Y se consigue gracias a proporcionar muchas y muchos datos a una neural network (red neuronal). Una red neuronal es un algoritmo que no se parece físicamente a una neurona, sino en cuanto a su funcionamiento. Su objetivo es solucionar un problema y tienen un éxito muy alto (siempre que se trate de tareas específicas, como la identificación de imágenes). Este algoritmo tiene muchos nodos y diferentes capas para procesar la información. Cada capa de la red neuronal trabaja con un nivel diferente, cuanto más profunda más complejidad. Aquí nace el término «Deep Learning»: actualmente las redes neuronales pueden llegar a tener miles de capas. Los datos entran por las capas de entrada, que se encargan de descomponerlas para poder analizar todos sus elementos. Después, son procesadas por capas más profundas, siempre mediante procesos operaciones matemáticas. Finalmente, el resultado es emitido por las capas de salidas con un lenguaje que un humano comprende. He aquí un ejemplo:

La clave está en cómo aprende esta red neuronal para identificar, por ejemplo, la imagen de un perro. Hay varios procedimientos, pero la gracia es que aprende de manera autónoma, gracias a una gran cantidad de datos y algoritmos de feedback, como el backpropagation. El caso es que los humanos desconocemos el proceso en este aprendizaje, solamente recibimos el resultado. Es decir, a este algoritmo se le proporcionan muchas fotos de perros etiquetadas y aquí comienza el proceso de aprendizaje. Después, se le dice: «identifica la imagen», por los imputs recibirá los píxeles de la imagen, los procesará a las capas profundas o «hidden layers» y como output tendremos una respuesta. Primero se equivocará (por ejemplo, recibirá una imagen de un gato y dirá que es un perro), pero el backpropagation le hará saber que se ha equivocado y con qué margen de error, y la red neuronal ajustará las operaciones y lo volverá a intentar. Después de un cierto tiempo, será capaz de identificar un perro con poco margen de error. Y aquí entra, pues, el big data, la obsesión actual por acumular datos y datos. Ya que para que pueda aprender necesitaremos miles de imágenes de perros diferentes etiquetadas.

Con el ejemplo del perro es muy sencillo, pero ¿Y si el objetivo es saber si un cliente reúne los requisitos para obtener un préstamo? Después de entrenar al sistema, le daremos información de clientes y nos dirá si reúnen las condiciones. Pero repetimos, no sabremos como se lo ha hecho para llegar porque desconocemos qué ocurre en las capas profundas.

¿Por qué es importante hablar de ética?

¿Qué papel juega la ética? Se ha estudiado mucho si ciertos comportamientos sociales son éticos, pero y los comportamientos virtuales? Podríamos pensar que en fondo son comportamientos perpetuados por personas mediante la tecnología, pero ya hemos visto que con la IA no es así: los sistemas de inteligencia artificial pueden resolver problemas muy cuidadosamente, pero no tienen nociones éticas para saber si el proceso puede ser negativo para la sociedad. El cofundador de empresas como PayPal o Tesla, Elon Musk, ya lo advirtió:

«Es como las historias en las que alguien convoca al demonio. Siempre existe el típico con una pentalfa y con agua bendita convencido de que así podrá controlarlo, y claro, no funciona».

No pretendemos decir que la inteligencia artificial es mala, sino que necesita regulación y un análisis desde una perspectiva ética. Vamos a ver algunos ejemplos.

Racismo y IA

Es un problema frecuente. Como el chatbot de Microsoft, se alimentaba con datos provenientes de las redes sociales, que se tuvo que desactivar por los comentarios racistas y ofensivos.

Los algoritmos de reconocimiento facial tienen problemas para distinguir mujeres negras. Hasta el punto de que IBM ha desaconsejado utilizar su propia tecnología. ¿La causa? Seguramente los datos que se usaron para entrenar el algoritmo no eran diversos y, por lo tanto, existe un sesgo.

El sesgo racista de la IA no termina aquí: el caso Loomis (2013) puso de manifiesto errores en los sistemas con IA que se utilizan para resolver casos judiciales.

The social dilema

Seguramente ya habéis visto este famoso documental (disponible en Netflix) que pone de manifiesto el potencial adictivo de las redes sociales, la capacidad para modificar la conducta humana para beneficiar el consumo y las repercusiones para la salud mental y los problemas sociales (polarización de la sociedad, desinformación) que todo ello conlleva.

¿La solución?

Como hemos dicho, no se trata de que la IA en sí sea buena o mala. De hecho, la inteligencia artificial nos puede ayudar: puede salvar vidas gracias a la rapidez y la precisión en el diagnóstico de células tumorales, por ejemplo. ¿Y cuál es el problema? En muchas ocasiones está relacionado con el sesgo de los datos, como hemos visto con la identificación facial. Por otra parte, la IA se ha convertido muchas veces en una herramienta para potenciar aspectos del neoliberalismo y simplemente satisface los intereses de unos cuantos, sin pensar en los problemas que conlleva (tal como nos cuenta Shoshana Zuboff con su teoría del capitalismo de vigilancia). ¿Entonces, podría ser también a la inversa?

Quizás la solución pasa por integrar disciplinas sociales en este campo puramente tecnológico que aporten un enfoque ético y así diseñar tecnologías responsables. Empiezan a aparecer iniciativas en esta dirección como las de Lorena Jaume-Palasí: AlgorithmWatch y The Ethical Tech Society. Y, por otra parte, una legislación al día que regulara estas cuestiones, es fundamental. El problema es que la ley avanza lentamente en comparación con la tecnología.

En definitiva, la inteligencia artificial es una herramienta muy potente, pero son los humanos quienes la dirigen y controlan los fines. Y en cuanto al proceso, no es tan fácil de controlar, pero deberíamos preguntarnos si el fin justifica los medios. Para nosotros la respuesta es que no, por lo tanto, es necesario estudiar qué ocurre en las capas ocultas de las redes neuronales, para conocer sus implicaciones sociales.