Què és la intel·ligència artificial? Parlem d’intel·ligència artificial (IA) quan una màquina pot aprendre a través de l’experiència per realitzar tasques o solucionar problemes. Potser relacionem intel·ligència artificial amb robòtica o, simplement, ens sembla ciència-ficció. És molt més que això: cada dia interactuem amb aplicacions que incorporen la intel·ligència artificial, sovint sense ser-ne conscients (per exemple, les recomanacions de compra d’Amazon o els vídeos recomanats de Youtube). Amazon, Google, Microsoft, Nvidia i Facebook són les principals empreses que inverteixen en IA. I per què ens hauria de preocupar l’ètica en aquest camp? Doncs perquè el Deep Learning (el nou sistema d’IA, tota una revolució) no sap què està bé i que no, només entén d’aconseguir els objectius fixats. Us ho expliquem.

Què és el Deep Learning?

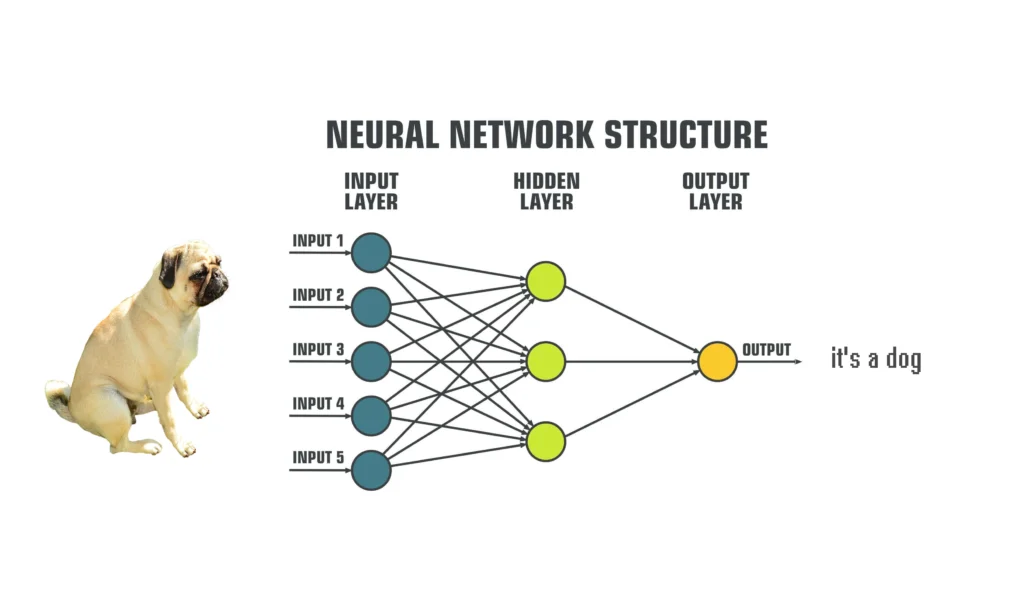

El Deep Learning es troba dins del machine learning. És un tipus d’IA que consisteix a fer que la màquina s’entreni per desenvolupar correctament tasques específiques. I s’aconsegueix gràcies a proporcionar moltes i moltes dades a una neural network. Una neural network és un algoritme que no s’assembla físicament a una neurona, però sí pel que fa al seu funcionament. El seu objectiu és solucionar un problema i tenen un èxit molt alt, sempre que es tracti de tasques específiques, com la identificació d’imatges. Aquest algoritme té molts nodes i diferents capes per a processar la informació. Cada capa de la neural network treballa amb un nivell diferent, com més profunda més complexitat. Aquí neix el terme “Deep Learning”: actualment les xarxes neuronals artificials poden arribar a tenir milers de capes. Les dades entren per les capes d’entrada, que s’encarreguen de descompondre-les per a poder analitzar tots els seus elements. Després, són processades per les capes més profundes, sempre mitjançant processos operacions matemàtiques. Finalment, el resultat és emès per les capes de sortides amb un llenguatge que un humà comprèn. Aquí teniu un exemple:

La clau està en com aprèn aquesta xarxa a identificar, per exemple, la imatge d’un gos. Hi ha diversos procediments, però la gràcia és que aprèn de manera autònoma, gràcies a una gran quantitat de dades i a algoritmes de feed-back, com el backpropagation. El cas és que els humans desconeixem el procés en aquests processos d’aprenentatge, només en rebem el resultat. És a dir, a aquest algoritme se li proporcionen moltes fotos de gossos etiquetades i aquí comença el procés d’aprenentatge. Després, se li diu: “identifica la imatge”, pels imputs rebrà els píxels de la imatge, els processarà a les capes profundes o “hidden layers” i com a output tindrem una resposta. Primer s’equivocarà (per exemple, rebrà una imatge d’un gat i dirà que és un gos), però el backpropagation li farà saber que s’ha equivocat i amb quin marge d’error, i la neural network ajustarà les operacions i ho tornarà a intentar. Després d’un cert temps, serà capaç d’identificar un gos amb poc marge d’error. I aquí entra, doncs, el big data, l’obsessió actual per acumular dades i dades. Ja que per tal que pugui aprendre necessitarem milers d’imatges de gossos diferents etiquetades.

Amb l’exemple del gos és molt senzill, però i si l’objectiu és saber si un client reuneix els requisits per obtenir un préstec? Després d’entrenar el sistema li donarem informació de clients i ens dirà si reuneixen les condicions. Repetim, no sabrem com s’ho ha fet per arribar-hi perquè desconeixem què passa a les capes profundes.

Per què és important parlar d’ètica?

Quin paper hi juga l’ètica? S’ha estudiat molt si certs comportaments socials són ètics, però i els comportaments virtuals? Podríem pensar que en fons són comportaments perpetuats per persones mitjançant la tecnologia, però ja hem vist que amb la IA no és així: els sistemes d’intel·ligència artificial poden resoldre problemes molt acuradament, però no tenen nocions ètiques per saber si el procés pot ser negatiu per la societat. El cofundador d’empreses com PayPal o Tesla, Elon Musk, ja ho va advertir:

“És com a les històries en les quals algú convoca al dimoni. Sempre hi ha el típic amb una pentalfa i amb aigua beneïda convençut de què així podrà controlar-lo, i clar, no funciona”.

No pretenem dir que la intel·ligència artificial és dolenta, sinó que necessita regulació i una anàlisi des d’una perspectiva ètica. Anem a veure alguns exemples.

Racisme i IA

És un problema freqüent. Com el chatbot de Microsoft, s’alimentava amb dades provinents de les xarxes socials, que es va haver de desactivar pels comentaris racistes i ofensius.

Els algoritmes de reconeixement facial tenen problemes per distingir dones negres. Fins al punt que IBM ha desaconsellat fer servir la seva pròpia tecnologia. La causa? Segurament les dades que es van fer servir per entrenar l’algoritme no eren diverses i per tant existeix un biaix.

El biaix racista de la IA no acaba aquí: el cas Loomis (2013) va posar en evidència errors en els sistemes amb IA que s’utilitzen per resoldre casos judicials.

The social dilema

Segur que ja heu vist aquest famós documental (disponible a Netflix) que posa de manifest el potencial addictiu de les xarxes socials, la capacitat per modificar la conducta humana per a beneficiar el consum i les repercussions per a la salut mental i els problemes socials (polarització de la societat, desinformació) que això comporta.

I quina és la solució?

Com hem dit, no es tracta del fet que la IA en si sigui bona o dolenta. De fet, la intel·ligència artificial ens pot ajudar, per exemple, pot salvar vides gràcies a la rapidesa i la precisió en el diagnòstic de cèl·lules tumorals. I quin és el problema? D’una banda, en moltes ocasions està relacionat amb el biaix de les dades, com hem vist amb la identificació facial. D’altra banda, la IA s’ha convertit moltes vegades en una eina per potenciar aspectes del neoliberalisme i simplement satisfà els interessos d’uns quants, sense pensar amb els problemes que comporta (tal com explica Shoshana Zuboff amb la seva teoria del capitalisme de vigilància). Llavors, podria ser també a la inversa?

Potser la solució demana integrar disciplines socials en aquest camp purament tecnològic que aportin un enfocament ètic i així dissenyar tecnologies responsables. Comencen a aparèixer iniciatives en aquesta direcció com les de Lorena Jaume-Palasí: AlgorithmWatch i The Ethical Tech Society. I, d’altra banda, una legislació al dia que regulés aquestes qüestions és fonamental. El problema és que la llei avança lentament en comparació amb la tecnologia.

En definitiva, la intel·ligència artificial és una eina molt potent, però són els humans qui la dirigeixen i en controlen les finalitats. I pel que fa al procés, no és tan fàcil de controlar, però ens hauríem de preguntar si el fi justifica els mitjans. Per a nosaltres la resposta és que no, per tant, cal estudiar què passa a les capes ocultes de les neurals networks, per tal de conèixer les implicacions socials.